![]()

1 Big Data – Anwendung und Nutzungspotentiale in der Produktion

Marion Steven, Timo Klünder1

1.1 Big Data als Treiber des digitalen Wandels

1.2 Informationstechnische Aspekte von Big Data

1.3 Betriebswirtschaftliche Aspekte von Big Data

1.4 Ausblick

Literatur

1.1 Big Data als Treiber des digitalen Wandels

Die systematische Analyse und Verknüpfung umfangreicher wählerbezogener Daten ermöglichte Wahlkämpfern im US-amerikanischen Präsidentschaftswahlkampf 2016. individuelle auf die Persönlichkeit des Wählers zugeschnittene Botschaften zu übermitteln. Im März 2018 wurde diese Form des Mikrotargetings durch den Whistleblower Christopher Wylie aufgedeckt und die Beteiligung des britischen Datenanalyse-Unternehmens »Cambridge Analytica« am US-amerikanischen Wahlkampf rückte den Begriff »Big Data« prominent in den Fokus öffentlicher Wahrnehmung. Betriebswirtschaftliche Einsatzszenarien bleiben vielfach unbeachtet, obwohl die hier durch den Einsatz von Big Data erreichten Fortschritte nicht minder beeindruckend sind. Der US-amerikanische Einzelhandelskonzern Walmart benötigt durch den Einsatz von Big Data zur Entwicklung eines Lösungsvorschlags für Störungen, wie Lieferverzögerungen oder Fehlmengen, nicht mehr durchschnittlich drei Wochen, sondern lediglich 20 Minuten (Marr 2016: 14 ff.).

Big Data setzt große oder zumindest komplexe Datenmengen voraus. Zwischen dem Beginn der Zivilisation und dem Jahr 2003 wurden 5 Exabyte (1018) Daten geschaffen. Dies ist eine Datenmenge, die heute innerhalb von zwei Tagen erzeugt wird. Diese gigantischen und komplexen Datenmengen besitzen das Potential, die Wertschöpfung der Unternehmen zu revolutionieren, stellen Unternehmen und Verantwortliche jedoch auch vor zahlreiche und neue informationstechnische wie betriebswirtschaftliche Herausforderungen und Fragestellungen:

• Was ist Big Data?

• Welche informationstechnische Infrastruktur ist die zwingende Voraussetzung für den erfolgreichen Umgang mit Big Data?

• Wie können Unternehmen Daten effizient organisieren und klassifizieren?

• Welche positiven und negativen Effekte resultieren aus der Nutzung von Big Data?

• Wie müssen betriebliche Funktionen in Reaktion auf Big Data neu gestaltet werden?

Die Lösung dieser und weiterer Herausforderungen und Fragestellungen ist die Zielsetzung der Beiträge dieses Sammelbands, der nicht am Anfang dieser Entwicklung erscheint, sondern mehr als 50 Jahre nach Beginn des sogenannten Datenzeitalters. Der aktuelle Trend-Begriff »Big Data« verfügt bereits über eine

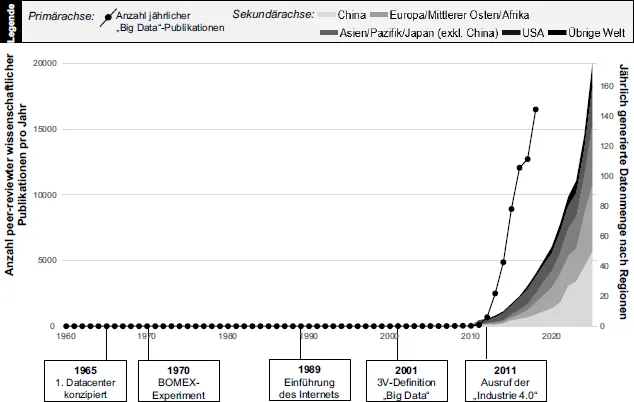

kurze Geschichte (u. a. Mülling 2018: 24 ff., King 2014: 22) (

Abb. 1):

Abb. 1: Eine kurze Geschichte von »Big Data«

• 1965 beschloss die Administration der Vereinigten Staaten, das erste Rechenzentrum zu bauen, in dem über 742 Millionen Steuererklärungen und 175 Millionen Fingerabdrücke gespeichert werden sollten, indem alle diese Datensätze auf Magnetband übertragen wurden, das an einem einzigen Ort aufbewahrt werden musste. Das Projekt wurde später aus Angst vor »Big Brother« eingestellt, aber es ist allgemein anerkannt, dass es der Beginn der Ära der elektronischen Datenspeicherung war. Die Bedenken, die »Big Data« heute hervorruft, sind somit nicht neu.

• Ebenfalls nicht neu ist der Big Data-Begriff selbst. Im Jahr 1970 fand der Begriff »Big Data« in einem Experiment im Inselstaat Barbados zur Untersuchung des Zusammenhangs zwischen physikalischen Eigenschaften des Wetters und des Ozeans erstmals Anwendung. Die nochmalige Verwendung des Begriffs ist erst für das Jahr 1997 dokumentiert.

• Am 12. März 1989 präsentierte Tim Berners-Lee am europäischen Kernforschungszentrum Cern ein Informationsmanagementsystem mit universellem Übertragungsstandard, das den Physikern den weltweiten freien Austausch von Informationen ermöglichte. Das Internet bildet für den überwiegenden Anteil aktueller Big Data-Anwendungen die Datenquelle, stellt Analysewerkzeuge bereit und ermöglicht die Anwendung der aus den Daten gewonnenen Erkenntnisse.

• Im Jahr 2001 definierte Laney Big Data als die aus dem Umfang (Volume), der Geschwindigkeit (Velocity) und der Vielfalt (Variety) resultierenden Komplexität der Datenverarbeitung. Jener 3V-Ansatz bildet den Ausgangspunkt aller auf dem V-Konzept basierenden Definitionen, die heute von den ursprünglichen drei V bis hin zu siebzehn V reichen. Verbreitet ist die 4V-Definition, welche Big Data als eine Kombination aus dem Umfang (Volume), der Geschwindigkeit (Velocity), der Vielfalt (Variety) und der Vertrauenswürdigkeit (Veracity) charakterisiert.

• Die aktuelle Begeisterung von Forschern und Praktikern für diesen Begriff wird jedoch vor allem durch die Industrie 4.0 und neuartige Datenquellen angetrieben.

Was haben fahrerlose Transportsysteme, Virtual und Augmented Reality oder die Blockchain gemeinsam? Es handelt sich um mehr oder weniger fortgeschrittene Technologien, die die technologische Basis der vierten industriellen Revolution, der sogenannten Industrie 4.0, repräsentieren. Der Begriff wurde 2011 auf der Hannover Messe Industrie eingeführt. Kennzeichnend für eine Industrielle Revolution sind Änderungen auf organisationaler Ebene, welche durch den flächendeckenden Einsatz neuartiger Technologien erreicht werden. Industrie 4.0 lässt sich daher ebenfalls über eine organisationale und eine technologische Komponente beschreiben (Steven und Klünder 2018: 203):

• Auf organisationaler Ebene wird Industrie 4.0 durch eine horizontale und vertikale Integration von Unternehmen charakterisiert, die unternehmensübergreifend in einer dezentral gesteuerten und sich selbstorganisierenden Wertschöpfungskette eine individualisierte, nachhaltige und flexible Produktion ermöglichen, durch die Zeit-, Kosten- und Qualitätsvorteile erzielt werden können.

• Diese organisationalen Wertschöpfungsveränderungen werden durch den vernetzten Einsatz von Big Data und echtzeitfähiger cyber-physischer Systeme im Internet der Dinge und Dienste technologisch vorangetrieben, sodass digital integrierte, autonome Smart Factories entstehen.

Industrie 4.0 hat zu einer

Wiederbelebung des Big Data-Begriffes geführt. Während die Zahl der mit dem Schlagwort »Big Data« indexierten Literatur zwischen 1960 und

2010 zwischen 0 und 31 Beiträgen pro Jahr lag, ist diese Zahl bis 2018 auf 16.505 Beiträge angewachsen (Eigene Berechnungen; Quelle: Datenbank Scopus) (siehe Primärachse

Abb. 1).

Parallel hierzu wuchs die jährlich generierte

Datenmenge ab 2011 exponentiell (siehe Sekundärachse

Abb. 1). Bis 2025 sollen, wenn man das aktuelle jährliche Wachstum durch die International Data Corporation fortschreibt, 175 Zettabyte Daten pro Jahr neu generiert werden. Eine beschriebene DIN-A4-Textseite umfasst 4 KB Daten, sodass es mit 175 Zettabyte ausgedruckter Daten auf DIN-A4-Papier möglich wäre, die Fläche der Erde 5.360.468-mal auszulegen. Auf jedem Fleck der Erde würden sich Papierstapel in einer Höhe von 536 Metern türmen. Die großen Industrienationen, USA, China und Europa, sind dabei die größten Datenproduzenten.

Welchen Mehrwert bietet der vorliegende Sammelband vor dem Hintergrund von 16.505 Publikationen zum Thema »Big Data« allein im Jahr 2018 und einer mehr als 50-jährigen Geschichte des Big Data-Begriffes?

• Ein Großteil der vorliegenden Publikationen ist rein informationstechnischer Ausrichtung ohne betriebs- oder produktionswirtschaftlichen Bezug.

• Es wird in diesen Publikationen nur sehr selten ein Industrie 4.0-Bezug hergestellt.

• Dieser Sammelband bewegt sich an der Schnittstelle von Informatik und Betriebswirtschaft, um ein ganzheitliches Bild von Big Data vor dem Hintergrund von Industrie 4.0 zu liefern.

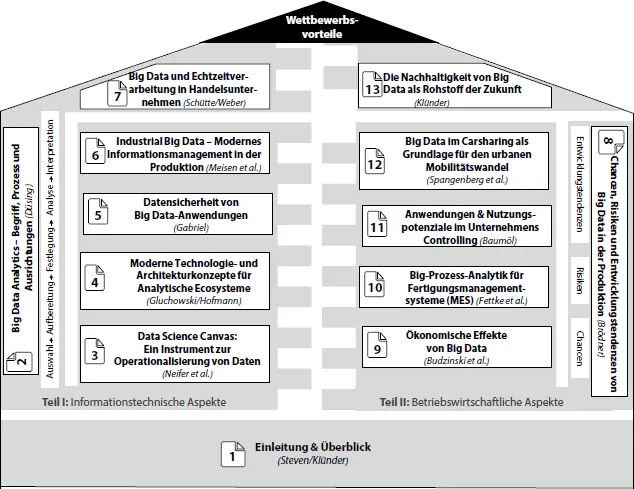

Um das Big Data-Phänomen umfassend zu erschließen, werden in den Beiträgen des vorliegenden Sammelbands die informationstechnischen und betriebswirtschaftlichen Aspekte zum erfolgreichen Einsatz von Big Data thematisiert. Hierauf aufbauend werden Wettbewerbspotentiale des Einsatzes von Big Data illustriert. Abbildung 2 gibt einen Überblick über den inhaltlichen Zusammenhang der Beiträge, die zwei komplementären Themenfeldern zugeordnet sind. Erst die erfolgreiche Lösung informationstechnischer und betriebswirtschaftlicher Herausforderungen ermöglicht die Generierung umfangreicher Wettbewerbsvorteile.

• In Teil I »Informationstechnische Aspekte« stehen die durch die digitale Transformation auslösten Veränderungen der Märkte und Wertschöpfungsbeziehungen im Vordergrund.

• Teil II »Betriebswirtschaftliche Aspekte« befasst sich mit den betrieblichen Nutzungspotentialen von Big Data und zeigt umfassend die Chancen, Risiken und Entwicklungstendenzen von Big Data auf.

Angesichts der schnellen Entwicklungen im Bereich von Industrie 4.0 können die Ausführungen zu diesen Themenfeldern nur eine Momentaufnahme darstellen und mögliche Entwicklungsszenarien für die Zukunft skizzieren.

Abb. 2: Aufbau des Sammelbands

1.2 Informationstechnische Aspekte von Big Data

Big Data wird in einer Studie mit 604 deutschen Unternehmen von 57 Prozent aller Unternehmen als wichtigste Technologie für eine zukünftig erfolgreiche unternehmerische Tätigkeit identifiziert (BITKOM 2018). Eine mangelnde Bekanntheit der Einsatzmöglichkeiten, Techniken und Methoden sowie Datenschutz- und Datensicherheitsbedenken hemmen den flächendeckenden Einsatz (Fraunhofer-Institut für intelligente Analyse- und Informationssysteme 2012: 48). In Teil I werden umfassend die informationstechnischen Aspekte erläutert, die in ihrer Gesamtheit einen entscheidenden Beitrag zum Abbau dieser Umsetzungsbarrieren leisten können.

Roland Düsing definiert im Beitrag Big Data Analytics – Begriff, Prozess und Ausrichtungen zunächst umfassend den Big Data-Begriff, um Big Data Analytics anschließend in das Gebiet der Datenanalyse einordnen zu können. Es wird gezeigt, dass ein Zusammenhang zwischen dem Knowledge Discovery in Databases (KDD) und Big Data Analytics besteht, sodass der aus den Phasen Auswahl, Aufbereitung, Festlegung, Analyse und Interpretation bestehende Prozess als Vorgehensmodell für die Untersuchung von Big Data Analytics herangezogen werden kann. Außerdem werden die Ausrichtungen Descriptive Analytics, Predictive Analytics und Prescriptive Analytics vorgestellt, deren erzeugte Modelle in Anwendungen als Beschreibungsmodelle, Erklärungsmodelle oder Entscheidungsmodelle herangezogen werden können.

Thomas Neifer, Andreas Schmidt, Paul Bossauer und Andreas Gadatsch entwickeln anschließend im Beitrag Data Science Canvas: Ein Instrument zur Operationalisierung von Daten eine Methode zur Entwicklung einer Datenstrategie, die sie anschließend exemplarisch auf die Produktionsleistung einer Photovoltaik-Anlage anwenden. Im eingangs von Roland Düsing dargestellten, aus fünf Phasen bestehenden Prozess ist dieses Kapitel der Auswahl und Aufbereitung von Daten zuzuordnen. Der Canvas-Gedanke strebt eine möglichst übersichtliche Zusammenfassung komplexer Problemstellungen an. In Anlehnung an das verbreitete »Businesss Model Canvas« wird der »Data Science Canvas« entwickelt, der für jegliche Fragestellungen der Datenanalyse anwendbar und auch für nicht datenaffine Fach- und Führungskräfte nutzbar ist, um Data Science Projekte planen, steuern und kontrollieren zu können. Dieses Konzept dient als Bindeglied zwischen der Führungskraft und dem Data Scientist. Methodenkarten dienen als Hilfestellung für nicht datenkompetente Fach- und Führungskräften, um sich intensiver mit Data Science und den unternehmenseigenen Potentialen auseinanderzusetzen.

Die erfolgreiche Umsetzung von Big Data-Initiativen steht auch im Zentrum des Beitrags Moderne Technologie- und Architekturkonzepte für Analytische Ecosysteme von Peter Gluchowski und Marcus Hofmann. Den traditionellen Architekturkonzepten stellen sie moderne Architekturkonzepte für eine Echtzeit- und Stapeldatenverarbeitung gegenüber. Das Architektu...