- 80 Seiten

- German

- ePUB (handyfreundlich)

- Über iOS und Android verfügbar

eBook - ePub

Gesichtserkennung

Über dieses Buch

Die Milliarden Gesichter, die in den Sozialen Medien zirkulieren, sind zur wertvollen Ressource geworden, abgeschöpft und bewirtschaftet von staatlichen wie kommerziellen Akteuren. Doch die Algorithmen der Gesichtserkennung sind fehleranfällig und keineswegs »neutral«: Sie verschärfen rassistische Diskriminierung und festigen Genderstereotype. Roland Meyer fragt nach den Konsequenzen der umstrittenen Technologie – und nach den Möglichkeiten, sich ihr subversiv zu entziehen.

Tools to learn more effectively

Saving Books

Keyword Search

Annotating Text

Listen to it instead

Information

Thema

ArtThema

Art General1 Faces in the Wild

Wann immer wir unser Gesicht einer Kamera zuwenden, müssen wir heute damit rechnen, dass es digital erfasst und ausgewertet wird. Von vielen unbemerkt sind die Milliarden von Selfies, Snapshots und Videoclips, die wir täglich hochladen, zur wertvollen Ressource geworden, die kommerzielle Unternehmen, staatliche Behörden und mittlerweile selbst Einzelpersonen abschöpfen und bewirtschaften. Um zu verstehen, wie es dazu kommen konnte, lohnt ein Blick in die Geschichte. Denn automatisierte Gesichtserkennung ist keine neue Technologie, sondern kann auf eine jahrzehntelange Entwicklung zurückblicken.7

An deren Beginn standen mäßig erfolgreiche Experimente mit dem rechnergestützten Abgleich von Fahndungsfotos, die in den 1960er-Jahren unbemerkt von der Öffentlichkeit im geheimdienstlichen Auftrag stattfanden. Doch schon 1970 konnte die Nippon Electric Company auf der Weltausstellung in Osaka eine Variante der Technologie publikumswirksam präsentieren. Im Rahmen der Attraktion »Computer Physiognomy« sollten die Proband*innen vom Rechner erfahren, welchen Prominenten ihr Gesicht besonders ähnlich sah, um anschließend ein digitales Porträt ihrer selbst ausgedruckt mit nach Hause zu nehmen. Osaka gab den Startschuss für die erste Welle der Forschung zur Gesichtserkennung. Doch trotz Erfolgen unter Laborbedingungen erwiesen sich die Probleme beim praktischen Einsatz als unlösbar, sodass die Forschung in den 1980er-Jahren stagnierte. Anders sah es auf der Kinoleinwand aus: Im James-Bond-Film Im Angesicht des Todes (A View to a Kill, 1986) ist es ausgerechnet der Schurke Zorin, der den inkognito auftretenden Doppelnull-Agenten mittels Gesichtserkennungssoftware zweifelsfrei identifiziert. Das war zwar reine Fiktion, doch sollte man deren Einfluss nicht unterschätzen. So ließ die technische Abteilung der CIA regelmäßig, wenn ein neuer Bond in die Kinos kam, die vorgeführten Gadgets auf ihre Realisierbarkeit hin prüfen. Und ohne die Flut von Filmen, die seit den 1980er-Jahren Gesichtserkennung als stets fehlerfrei funktionierende Technologie vorführten, hätte sich deren Durchsetzungsprozess sicherlich länger hingezogen.

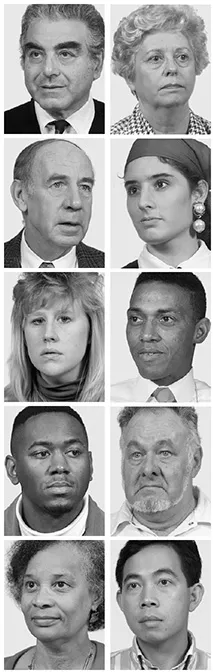

Dieser nahm in den späten 1990er-Jahren an Fahrt auf, als automatisierte Gesichtserkennung erstmals als kommerzielles Produkt vertrieben wurde. Maßgeschneiderte Anwendungen richteten sich etwa an Casinos, Stadionbetreiber und sogar an Privatleute, die ihren PC vor unerlaubtem Zugriff sichern wollten. Vorangegangen war dem ein Paradigmenwechsel der Forschung. Hatten die frühen Systeme auf die Vermessung einzelner stabiler Größen wie etwa Augenabstände gesetzt (# 2), kam 1991 ein neuer Ansatz auf, der auf der statistischen Auswertung von Helligkeitsverteilungen im ganzen Gesicht basierte. Beim sogenannten Eigenface-Verfahren wurden keine anatomischen Merkmale mehr erfasst, die sich auch am lebendigen Gesicht hätten abmessen lassen, vielmehr glich der Algorithmus digitale Bilddatensätze in Hinblick auf statistische Differenzen ab, die sich nur noch nachträglich für Menschenaugen als geisterhafte Schemen visualisieren ließen. (# 3) Dieser neue, »holistische« statt »merkmalsbasierte« Ansatz löste einen wahren Forschungsboom aus – wesentlich befördert durch das von der US-Regierung finanzierte FERET-Programm,8 bei dem zwischen 1994 und 1996 jeweils die vielversprechendsten Algorithmen aus den universitären Computerlaboren in standardisierten Tests gegeneinander antraten. Dabei konkurrierten Algorithmen, die das Eigenface-Verfahren nutzten, mit solchen, die auf verbesserten merkmalsbasierten Ansätzen oder Kombinationen beider Verfahren beruhten. Um die Vergleichbarkeit der Ergebnisse zu garantieren, wurde eigens eine Bilddatenbank aufgebaut, für die Hunderte von Mitarbeiter*innen eines Army Research Laboratory unter standardisierten Bedingungen digital fotografiert wurden. Der Künstler Trevor Paglen hat eine Auswahl der damals entstandenen Porträts 2017 ins Zentrum einer Arbeit gestellt. Ihr Titel: It Began as a Military Experiment. (# 4)

#2 Takeo Kanade, Schema der merkmalsbasierten Gesichtserkennung, 1977

#3 Matthew Turk und Alex Pentland, Eigenfaces zur Gesichtserkennung, erstmals 1991

Dieses »militärische Experiment« bereitete den Boden für die Kommerzialisierung der Technologie, benutzten doch manche der beteiligten Forscher*innen die Testergebnisse, um mit ihnen Risikokapital für ihre neu gegründeten Firmen einzuwerben. Und die drängten dahin, wo staatliche Aufträge das meiste Geld versprachen: in die Videoüberwachung des öffentlichen Raums. Ein früher Feldversuch fand im Sommer 2001 in der Innenstadt von Tampa (Florida) statt. Eine bestehende Videoüberwachungsanlage sollte hier mittels Gesichtserkennung zum »Smart CCTV« aufgerüstet werden, um nach gesuchten Kriminellen zu fahnden. Doch das System war nicht besonders smart: Es häuften sich die Fehlalarme, und nach wenigen Wochen Laufzeit beendete die Polizei still und heimlich den Versuch.9 Echtzeitgesichtserkennung wurde seitdem immer wieder in Pilotprojekten getestet, in Deutschland zuletzt 2017/18 am Berliner Bahnhof Südkreuz. Und obwohl sich die Technologie in der Zwischenzeit deutlich verbessert hatte, erwies sie sich einmal mehr als für den flächendeckenden Einsatz untauglich – auch wenn die Verantwortlichen zunächst das Gegenteil behaupteten. Denn selbst die schöngerechneten Erkennungsraten im Pilotversuch hätten, wie der Chaos Computer Club in seiner Kritik des Abschlussberichts herausstellte, im Praxiseinsatz bedeutet, dass Tag für Tag Hunderte von Reisenden fälschlich aufgehalten worden wären, während zugleich von den wenigen gesuchten Personen ein hoher Prozentsatz unerkannt geblieben wäre.10

#4 Trevor Paglen, It Began as a Military Experiment, 2017

Der Erfolg einer Technologie entscheidet sich jedoch nicht unbedingt daran, was sie tatsächlich leistet. Entscheidend sind vielmehr die Erwartungen, die sich an sie knüpfen. In dieser Hinsicht sollte der 11. September 2001 alles verändern: Nach den Anschlägen auf die Twin Towers ließ sich dieselbe Technologie, die kurz zuvor – von der Öffentlichkeit unbemerkt – im polizeilichen Feldversuch gescheitert war, als wichtigste Waffe im »Kampf gegen den Terror« vermarkten. Letztlich blieben die Anwendungsfelder jedoch zunächst sehr begrenzt – halbwegs zuverlässig einsetzbar war Gesichtserkennung nur dort, wo sie wie etwa bei der Passkontrolle lediglich standardisierte Vergleichsbilder miteinander abzugleichen hatte. Die strengen Regeln, die seit 2005 für die Anfertigung sogenannter biometrischer Passbilder gelten, legen davon Zeugnis ab: Bis vor gut zehn Jahren funktionierte Gesichtserkennung halbwegs zuverlässig nur bei frontalem Blick, neutralem Hintergrund und unbewegter Mimik. Ihr Einsatzbereich beschränkte sich folglich auf Grenzübergänge und andere Orte, an denen man die zu identifizierenden Subjekte dazu bringen konnte, unter kontrollierten Aufnahmebedingungen in eine Kamera zu schauen.

Das sollte sich mit einer Technologie ändern, die in den letzten Jahren Furore machte und wesentlich für den aktuellen Hype um sogenannte Künstliche Intelligenz (KI) verantwortlich ist: dem »Deep Learning«. Dabei handelt es sich um eine Form maschinellen Lernens mittels sogenannter künstlicher neuronaler Netze. Die Grundidee dazu, die von der Funktionsweise des menschlichen Gehirns inspiriert ist, stammt zwar schon aus den 1940er-Jahren, aber erst um 2010 waren die Bedingungen gegeben, um damit auf dem Feld der Gesichtserkennung hinreichend überzeugende Resultate zu erzielen – neben gestiegener Rechenleistung war das vor allem die massenhafte Verfügbarkeit der nötigen Trainingsdaten. Denn anders als bei älteren Verfahren der Gesichtserkennung muss künstlichen neuronalen Netzen nicht vorgegeben werden, woran sie ein Gesicht erkennen können, sondern sie »lernen« dies durch millionenfachen Versuch und Irrtum.11

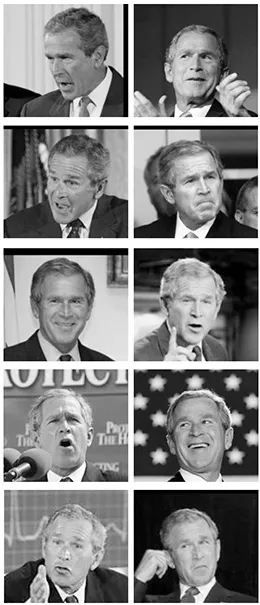

Um etwa zu trainieren, ein und dasselbe Gesicht in unterschiedlichen Situationen, aus verschiedenen Perspektiven und bei wechselnden Lichtverhältnissen zuverlässig demselben Namen zuzuordnen, werden künstliche neuronale Netze mit riesigen Mengen von Bilderserien gefüttert, die anders als die institutionellen Bilddatenbanken der 1990er-Jahre nicht unter standardisierten, sondern unter realweltlichen Bedingungen aufgenommen wurden – sogenannte faces in the wild. Entscheidend für den Trainingsprozess ist, dass diese Gesichter »in freier Wildbahn« bereits »gelabelt«, also zum Beispiel mit dem Namen einer Person verknüpft sind. Sollen die Algorithmen trainiert werden, Gesichter nicht nur zu identifizieren, sondern andere Eigenschaften aus ihnen abzulesen, wie beispielsweise das Alter, das Geschlecht oder die emotionale Stimmung einer Person, brauchen sie auch dafür entsprechende Labels (siehe Kap. 3). Auf Basis dieser gelabelten Trainingsdaten »lernen« die neuronalen Netze dann nicht nur, auf welche »Merkmale« sie zu achten haben, sie bestimmen auch autonom im Trainingsprozess, was überhaupt ein Merkmal ist. Und diese Merkmale müssen kein offensichtliches Äquivalent im Bild haben, denn künstliche neuronale Netze »sehen« nicht wie Menschenaugen, sondern suchen nach statistischen Mustern in Datenmengen.12

Woher aber kommen nun diese Trainingsgesichter? Wir alle liefern sie. Einer der ersten Trainingsdatensätze von 2007, schlicht »Labeled Faces in the Wild« benannt, versammelte noch vorwiegend Gesichter von Filmstars und Politiker*innen, die von diversen News-Seiten stammten. (#5) Doch seit immer mehr Bilder von gewöhnlichen Leuten im Netz zirkulieren, kann es uns allen passieren, dass unser Gesicht zum Training künstlicher neuronaler Netze genutzt wird. Der Künstler Adam Harvey beschäftigt sich seit Jahren mit Trainingsdatensätzen. Seinen Recherchen ist es zu verdanken, dass Microsoft seine seit 2014 aufgebaute, öffentlich zugängliche Gesichterdatenbank »MS-Celeb« kürzlich vom Netz nehmen musste. »Celeb« stand zwar für »Celebrity«, doch Microsoft hatte eine überaus inklusive Vorstellung von Berühmtheit: Namen und Gesichter von rund 100 000 Menschen waren in der Datenbank gelandet, unter ihnen auch viele Künstler*innen, Wissenschaftler*innen und Journalist*innen, die sich wie Harvey kritisch mit Überwachung beschäftigen.13

Und es sind nicht allein unsere Gesichter, die seit gut einem Jahrzehnt für die Entwicklung der Gesichtserkennung massenhaft abgeschöpft werden. Auch unsere Mitarbeit ist gefragt: Wann immer etwa Facebook oder Google Photos uns auffordern, ein Gesicht auf einem Bild zu identifizieren oder einen automatisch generierten Vorschlag zu bestätigen, wirken wir beim Training der Algorithmen mit. Denn das Labeling, also die Identifizierung und Klassifizierung von Trainingsdatensätzen, ist einer der aufwendigsten und teuersten Aspekte des Deep Learning – wenn man ihn nicht an die unbezahlte Clickarbeit von Milliarden von User*innen outsourcen kann.14 Kein Wunder also, dass Soziale Medien zum wichtigsten Trainings- und Testgelände für Gesichtserkennung und andere Formen der automatisierten Bildauswertung geworden sind. Gesichtserkennung in ihrer heutigen Form ist das Produkt einer digitalen Bildkultur, die riesige Mengen gelabelter Gesichter mühelos verfügbar gemacht hat. Die Skrupellosigkeit von Firmen wie Clearview AI und PimEyes kommt also nicht von ungefähr – sie ist vielmehr die zugespitzte Konsequenz eines grenzenlosen »Überwachungskapitalismus«, dessen Geschäftsmodell darauf basiert, alle Datenspuren, die wir online hinterlassen, systematisch zu erfassen und kommerziell auszuwerten.15

#5 Bilder von George W. Bush aus dem »Labeled Faces in the Wild«-Datensatz

Was dabei jedoch mit unseren digitalen Gesichtern geschieht, bleibt strukturell verborgen, und zwar nicht allein, weil sich die Techfirmen ungern in die Karten schauen lassen. Mehr als jede frühere Form ko...

Inhaltsverzeichnis

- Cover

- Impressum

- Digitale Bildkulturen

- Einleitung

- 1 Faces in the Wild

- 2 Automatisierte Diskriminierung

- 3 Muster und Labels

- 4 Maskierungen

- 5 Gesichter ohne Körper

- 6 Was tun?

- Anmerkungen

- Abbildungsnachweis

- Widmung

- Über den Autor

Häufig gestellte Fragen

Ja, du kannst dein Abo jederzeit über den Tab Abo in deinen Kontoeinstellungen auf der Perlego-Website kündigen. Dein Abo bleibt bis zum Ende deines aktuellen Abrechnungszeitraums aktiv. Erfahre, wie du dein Abo kündigen kannst

Nein, Bücher können nicht als externe Dateien, z. B. PDFs, zur Verwendung außerhalb von Perlego heruntergeladen werden. Du kannst jedoch Bücher in der Perlego-App herunterladen, um sie offline auf deinem Smartphone oder Tablet zu lesen. Erfahre, wie du Bücher herunterladen kannst, um sie offline zu lesen

Perlego bietet zwei Abopläne an: Elementar und Erweitert

- Elementar ist ideal für Lernende und Profis, die sich mit einer Vielzahl von Themen beschäftigen möchten. Erhalte Zugang zur Basic-Bibliothek mit über 800.000 vertrauenswürdigen Titeln und Bestsellern in den Bereichen Wirtschaft, persönliche Weiterentwicklung und Geisteswissenschaften. Enthält unbegrenzte Lesezeit und die Standardstimme für die Funktion „Vorlesen“.

- Pro: Perfekt für fortgeschrittene Lernende und Forscher, die einen vollständigen, uneingeschränkten Zugang benötigen. Schalte über 1,4 Millionen Bücher zu Hunderten von Themen frei, darunter akademische und hochspezialisierte Titel. Das Pro-Abo umfasst auch erweiterte Funktionen wie Premium-Vorlesen und den Recherche-Assistenten.

Wir sind ein Online-Lehrbuch-Abo, bei dem du für weniger als den Preis eines einzelnen Buches pro Monat Zugang zu einer ganzen Online-Bibliothek erhältst. Mit über 1 Million Büchern zu über 990 verschiedenen Themen haben wir bestimmt alles, was du brauchst! Erfahre mehr über unsere Mission

Achte auf das Symbol zum Vorlesen bei deinem nächsten Buch, um zu sehen, ob du es dir auch anhören kannst. Bei diesem Tool wird dir Text laut vorgelesen, wobei der Text beim Vorlesen auch grafisch hervorgehoben wird. Du kannst das Vorlesen jederzeit anhalten, beschleunigen und verlangsamen. Erfahre mehr über die Funktion „Vorlesen“

Ja! Du kannst die Perlego-App sowohl auf iOS- als auch auf Android-Geräten nutzen, damit du jederzeit und überall lesen kannst – sogar offline. Perfekt für den Weg zur Arbeit oder wenn du unterwegs bist.

Bitte beachte, dass wir Geräte, auf denen die Betriebssysteme iOS 13 und Android 7 oder noch ältere Versionen ausgeführt werden, nicht unterstützen können. Mehr über die Verwendung der App erfahren

Bitte beachte, dass wir Geräte, auf denen die Betriebssysteme iOS 13 und Android 7 oder noch ältere Versionen ausgeführt werden, nicht unterstützen können. Mehr über die Verwendung der App erfahren

Ja, du hast Zugang zu Gesichtserkennung von Roland Meyer im PDF- und/oder ePub-Format sowie zu anderen beliebten Büchern aus Art & Art General. Aus unserem Katalog stehen dir über 1 Million Bücher zur Verfügung.